- CALCUL NUMÉRIQUE (HISTOIRE DU)

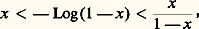

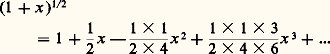

- CALCUL NUMÉRIQUE (HISTOIRE DU)Dans l’enseignement des mathématiques en France, le calcul numérique apparaît le plus souvent comme une simple application des théories. Au contraire, l’histoire des mathématiques montre, comme on va le voir, qu’il y a interaction constante entre les progrès du calcul et l’approfondissement des concepts mathématiques. Cependant, l’intérêt pour les problèmes numériques est d’importance variable suivant les époques. L’école platonicienne (Platon, Eudoxe, Euclide...) distingue nettement l’arithmétique, laquelle fait partie des mathématiques, du calcul numérique (appelé logistique), considéré comme science pratique. Une évolution importante apparaît avec l’école d’Alexandrie (Archimède, Héron...), en relation avec les progrès de la géographie et de l’astronomie: les mathématiciens sont alors amenés à combiner les méthodes grecques et les méthodes babyloniennes. C’est encore l’astronomie qui favorise le développement de l’algèbre et du calcul numérique dans l’école arabe au Moyen Âge.En Occident, il convient de distinguer plusieurs périodes. De 1500 à 1650, le développement du calcul numérique est lié aux problèmes posés par les échanges commerciaux, la navigation et l’astronomie (Stevin, Viète, Napier, Briggs, Kepler, Mercator, Descartes, Wallis, Gregory). De 1650 à 1800, les progrès des sciences physiques, du calcul des probabilités et des statistiques sont à la source de nombreux travaux, aussi bien en Grande-Bretagne (Newton, Maclaurin, Stirling...) que sur le continent (Euler, Lagrange, Laplace, Gauss...). Au début du XIXe siècle, l’école française (Fourier, Poisson, Ampère, Cauchy...) élabore les éléments de la physique mathématique, laquelle pose de nouveaux problèmes numériques. Au cours du XIXe siècle, ces travaux seront approfondis notamment par Jacobi, Tchebychev et Hermite. Toutefois, de nombreuses questions ne peuvent alors être résolues, par manque de moyens de calcul: ce qui peut expliquer un certain déclin de l’intérêt pour les questions numériques à la fin du XIXe siècle, et ce jusqu’en 1940. Les développements de la recherche opérationnelle d’une part, de la physique nucléaire d’autre part, eux-mêmes liés à l’histoire de la Seconde Guerre mondiale, ont abouti à la création des ordinateurs; ceux-ci ont, en retour, complètement bouleversé les conceptions concernant le calcul numérique. Depuis cette époque, de très nombreux travaux sont consacrés à l’analyse numérique et à l’informatique, au service des problèmes scientifiques et techniques. Les moyens de calcul ont ensuite envahi la gestion à tous les niveaux. Grâce à l’apparition des calculatrices de poche vers 1970, bon nombre de ces moyens de calcul ont été mis à la disposition des individus, y compris pour les problèmes posés par la vie courante, reléguant au grenier de l’histoire tables de logarithmes et autres règles à calcul. Il convient de souligner le rôle ambigu des progrès en ces matières: les tables et les règles ont eu des effets positifs pendant une longue période, mais elles ont fini par être des obstacles à la recherche de moyens de calcul plus puissants et plus rapides.Il est à noter que l’influence de cette révolution sur l’enseignement français a connu quelques lenteurs: l’analyse numérique et l’informatique ont été introduites dans les cursus des écoles d’ingénieurs et les universités vers 1960. L’emploi des calculatrices de poche est mis en vigueur dans les classes préparatoires aux grandes écoles scientifiques en 1978; il a été ensuite étendu pour tous les examens.Enfin, à toutes les époques, le calcul numérique a permis de formuler des conjectures dans des secteurs mathématiques très variés. Les travaux sur la répartition des nombres premiers de Legendre, Gauss et Dirichlet sont à cet égard célèbres. L’emploi des ordinateurs est maintenent courant, notamment pour les conjectures concernant les équations diophantiennes et les équations aux dérivées partielles. On a même effectué des démonstrations sur ordinateur, par une étude exhaustive de cas trop nombreux pour être étudiés à la main: citons, par exemple, en topologie algébrique, le problème des quatre couleurs. Ces conjectures peuvent porter sur l’analyse numérique elle-même. En effet, il y a deux façons d’apprécier l’efficacité d’un processus de calcul: on teste ce processus sur des exemples déjà maîtrisés par d’autres méthodes, ou bien on démontre un résultat théorique assurant la convergence et permettant de mesurer la rapidité de cette convergence. L’histoire des mathématiques montre que ces deux aspects interviennent de manière dialectique et que, le plus souvent, la phase expérimentale précède la phase déductive. Les mathématiques sont donc aussi une science expérimentale.Le calcul sur les nombres réelsDéveloppements décimauxNous ne traiterons pas ici des différents systèmes de numération [cf. NUMÉRATION].On sait que l’école platonicienne considérait que seuls les entiers naturels non nuls sont des nombres. Par ailleurs, la théorie des grandeurs (Euclide, livres V et X) fournit un cadre très malaisé pour le calcul sur les rapports non entiers. Les mathématiciens de l’école alexandrine, en particulier Archimède (287-212 av. J.-C.), Héron (Ier siècle) et Diophante (325-410), développent le calcul sur les fractions et sur les racines carrées. Ces difficultés persisteront en Occident jusqu’au XVIe siècle, comme en témoigne la terminologie de nombres absurdes, irrationnels, irréguliers, inexplicables, sourds, rompus, etc.C’est la construction du système décimal, motivée en particulier par les nécessités du commerce, qui va permettre d’unifier le domaine numérique, comme en témoigne l’œuvre de Simon Stevin (1548-1620). Le système décimal est exposé dans L’Arithmétique (1585), sous le titre: «La disme enseignant facilement expedier par nombres entiers sans rompuz, tous comptes se rencontrans aux affaires des Hommes». Stevin insiste sur le fait que la représentation décimale illimitée permet d’assimiler les irrationnels à de véritables nombres, puisqu’ils ont les mêmes propriétés opératoires. Dans le Traité des incommensurables grandeurs (paru en 1634), Stevin approfondit la notion théorique de nombre réel ; il affirme que les difficultés rencontrées par les mathématiciens dans la mesure des grandeurs (cf. Euclide, livre X) viennent du fait «qu’ils ne tenaient pas les radicaux pour nombres, mais pour quantités sourdes, absurdes... et pas dignes d’être citées en propositions mathématiques». Cette nouvelle conception a eu une grande influence, non seulement pour la construction des nombres réels [cf. WEIERSTRASS (K. T. W.)], mais aussi pour l’élaboration du calcul différentiel: Newton, dans La Méthode des fluxions et des suites infinies , écrite vers 1671, s’appuie sur une analogie avec la théorie des développements décimaux pour unifier le champ des fonctions, grâce au concept de développement en série entière (cf. CALCUL INFINITÉSIMAL - Calcul à une variable). De même que les développements décimaux expriment, à l’aide de nombres entiers, les fractions et les nombres définis par des radicaux, les développements en série entière expriment, à l’aide de monômes, les fonctions rationnelles et les fonctions définies par des radicaux. Le développement du binôme joue ici un rôle essentiel. Le calcul des dérivées de telles fonctions en découle aussitôt.Les logarithmesAu départ, Napier (1550-1617) se propose de simplifier les calculs trigonométriques intervenant en astronomie; en 1614, il publie une table de logarithmes à sept décimales, sous le titre: Description des merveilleuses règles des logarithmes et de leur usage dans l’une et l’autre trigonométrie, aussi bien que dans tout calcul mathématique . Un second traité, publié en 1619, explique la construction des tables de logarithmes. La définition des logarithmes s’appuie sur la comparaison de deux mouvements, l’un uniforme, l’autre où la vitesse est à chaque instant proportionnelle au chemin parcouru. En outre, des inégalités interpolatoires sont établies. En particulier, Napier montre que, pour tout nombre réel x appartenant à l’intervalle ]0, 1[,

ce qui permet de calculer les logarithmes des nombres voisins de 1. Il prouve aussi que, si 0 麗x 麗 y , alors:

ce qui permet de calculer les logarithmes des nombres voisins de 1. Il prouve aussi que, si 0 麗x 麗 y , alors: ce qui permet d’interpoler les logarithmes.Briggs (1561-1631) perfectionne la construction des logarithmes: d’une part, il met en évidence l’importance de la relation fonctionnelle:

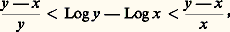

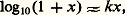

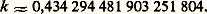

ce qui permet d’interpoler les logarithmes.Briggs (1561-1631) perfectionne la construction des logarithmes: d’une part, il met en évidence l’importance de la relation fonctionnelle: d’autre part, il perçoit l’avantage des logarithmes décimaux. En 1617, il publie une table à quatorze décimales. Il utilise la correspondance entre une suite arithmétique et une suite géométrique. Il calcule les logarithmes des nombres voisins de 1 par extractions successives de racines carrées, en se servant de la relation:

d’autre part, il perçoit l’avantage des logarithmes décimaux. En 1617, il publie une table à quatorze décimales. Il utilise la correspondance entre une suite arithmétique et une suite géométrique. Il calcule les logarithmes des nombres voisins de 1 par extractions successives de racines carrées, en se servant de la relation:

L’extraction des racines carrées est facilitée par un algorithme employant des différences successives, ce qui revient à la relation:

L’extraction des racines carrées est facilitée par un algorithme employant des différences successives, ce qui revient à la relation: Une nouvelle étape est franchie par Grégoire de Saint-Vincent (1584-1667), qui met en relation les logarithmes avec les aires limitées par une hyperbole. Mercator (1620-1687) et Newton (1642-1727) obtiennent indépendamment le développement en série:

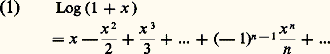

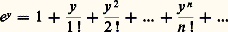

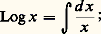

Une nouvelle étape est franchie par Grégoire de Saint-Vincent (1584-1667), qui met en relation les logarithmes avec les aires limitées par une hyperbole. Mercator (1620-1687) et Newton (1642-1727) obtiennent indépendamment le développement en série: Newton explicite à ce propos la série exponentielle:

Newton explicite à ce propos la série exponentielle: En outre, il donne une méthode permettant de calculer les logarithmes népériens à partir de la série (1), grâce à des manipulations ingénieuses portant sur cette série.Ainsi, la théorie des logarithmes met en jeu des concepts importants:– elle contribue à l’élaboration de la notion de fonction: Newton et Leibniz (1646-1716) conçoivent clairement la fonction logarithme, et utilisent la relation:

En outre, il donne une méthode permettant de calculer les logarithmes népériens à partir de la série (1), grâce à des manipulations ingénieuses portant sur cette série.Ainsi, la théorie des logarithmes met en jeu des concepts importants:– elle contribue à l’élaboration de la notion de fonction: Newton et Leibniz (1646-1716) conçoivent clairement la fonction logarithme, et utilisent la relation: Jean Bernoulli (1667-1748) développe le calcul sur les fonctions exponentielles et logarithmes, d’une importance capitale en analyse, en particulier dans la résolution des équations différentielles;– les notions de cinématique employées par Napier sont reprises et généralisées par Newton pour fonder le calcul différentiel (méthode des fluxions);– les développements obtenus par Briggs pour 連1 + x sont généralisés par Newton (développement du binôme, développements en série entière);– les problèmes d’interpolation sont à la base des travaux de Gregory (1638-1675) et de ceux de Newton sur les différences finies;– enfin, on trouve un exposé synthétique des fonctions exponentielles et logarithmes dans l’Introduction à l’analyse des infiniment petits , publiée en 1748 par Euler (1707-1783); ce dernier dégage en outre le lien entre les fonctions exponentielles réelles et les fonctions circulaires, grâce à la théorie des fonctions exponentielles et logarithmes complexes [cf. EXPONENTIELLE ET LOGARITHME].Recherche de solutions approchées d’équations numériquesMéthode de dichotomieSoit g une fonction numérique continue et strictement monotone sur un intervalle [a , b ], telle que g (a )g (b ) 麗 0. Il existe alors un élément 見 de [a , b ] et un seul tel que g ( 見) = 0. On peut trouver des valeurs approchées de 見 par l’algorithme suivant: supposons par exemple g (a ) 礪 0 et g (b ) 麗 0; posons a 0 = a , b 0 = b , et:

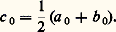

Jean Bernoulli (1667-1748) développe le calcul sur les fonctions exponentielles et logarithmes, d’une importance capitale en analyse, en particulier dans la résolution des équations différentielles;– les notions de cinématique employées par Napier sont reprises et généralisées par Newton pour fonder le calcul différentiel (méthode des fluxions);– les développements obtenus par Briggs pour 連1 + x sont généralisés par Newton (développement du binôme, développements en série entière);– les problèmes d’interpolation sont à la base des travaux de Gregory (1638-1675) et de ceux de Newton sur les différences finies;– enfin, on trouve un exposé synthétique des fonctions exponentielles et logarithmes dans l’Introduction à l’analyse des infiniment petits , publiée en 1748 par Euler (1707-1783); ce dernier dégage en outre le lien entre les fonctions exponentielles réelles et les fonctions circulaires, grâce à la théorie des fonctions exponentielles et logarithmes complexes [cf. EXPONENTIELLE ET LOGARITHME].Recherche de solutions approchées d’équations numériquesMéthode de dichotomieSoit g une fonction numérique continue et strictement monotone sur un intervalle [a , b ], telle que g (a )g (b ) 麗 0. Il existe alors un élément 見 de [a , b ] et un seul tel que g ( 見) = 0. On peut trouver des valeurs approchées de 見 par l’algorithme suivant: supposons par exemple g (a ) 礪 0 et g (b ) 麗 0; posons a 0 = a , b 0 = b , et: Si g (c 0) 諒 0, on pose a 1 = a 0 et b 1 = c 0; sinon, on pose a 1 = c 0 et b 1 = b 0. Par récurrence, on construit une suite ([a n , b n ]) d’intervalles emboîtés telle que, pour tout entier naturel n , on ait g (a n ) 礪 0, g (b n ) 諒 0 et:

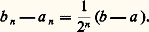

Si g (c 0) 諒 0, on pose a 1 = a 0 et b 1 = c 0; sinon, on pose a 1 = c 0 et b 1 = b 0. Par récurrence, on construit une suite ([a n , b n ]) d’intervalles emboîtés telle que, pour tout entier naturel n , on ait g (a n ) 礪 0, g (b n ) 諒 0 et: Les suites (a n ) et (b n ) sont adjacentes, et elles convergent toutes deux vers 見. En outre, pour tout entier naturel n , 見 appartient à l’intervalle [a n ,b n ].Dès le XVIe siècle, cette méthode est employée pour séparer les racines d’une équation algébrique. La convergence n’est pas très rapide; c’est pourquoi cette méthode n’est pas utilisée lorsqu’on désire obtenir 見 avec une grande précision.En revanche, le méthode de dichotomie a eu une importance considérable dans le développement des concepts fondamentaux de l’analyse:– Lagrange (1736-1813), dans La Théorie des fonctions analytiques (1797), utilise une variante de cette méthode pour démontrer le principe fondamental du calcul différentiel, suivant lequel une fonction admettant une dérivée positive est croissante; ce principe est à la base de la formule de Taylor.– Bolzano (1781-1848), dans Une preuve analytique ... (1817) et Cauchy (1789-1857), dans son Cours d’analyse à l’École polytechnique (1821), utilisent la dichotomie pour démontrer le théorème des valeurs intermédiaires.– L’école de Weierstrass (1815-1897) utilise systématiquement la dichotomie pour démontrer les théorèmes fondamentaux sur les fonctions continues (existence d’un maximum, continuité uniforme). Ces résultats reposent sur le théorème suivant, dit de Bolzano-Weierstrass: de toute suite bornée de nombres réels, on peut extraire une suite convergente.Méthode d’interpolation linéaire (ou «regula falsi»)Sous les mêmes hypothèses que précédemment, on cherche une valeur approchée 廓 de 諸 en interpolant g sur l’intervalle [a ,b ] par une fonction affine 﨏, et en définissant 廓 par la relation 﨏( 廓) = 0. Cette méthode a été utilisée par Viète (1540-1603) et par Descartes (1596-1650), dans le cas des équations algébriques. La majoration de l’erreur a été effectuée par Lagrange.Cette méthode est peu employée seule car elle ne conduit pas à un processus itératif qui soit à la fois commode et performant.Méthode des tangentes (ou de Newton)L’école d’Alexandrie, et en particulier Archimède, utilise fréquemment des encadrements des racines carrées d’un nombre entier par des nombres rationnels. À cet effet, on utilise l’algorithme d’Euclide de divisions successives. Héron d’Alexandrie part d’une autre idée. Pour approcher 連a , il écrit a sous la forme a = r 2 + b , où r est le plus grand des entiers p tels que p 2 諒 a . Ainsi, 連a = r 連1 + (b /r 2). Il approche 連1 + (b /r 2) par 1 + (b /2r 2). D’où la valeur approchée suivante:

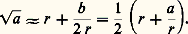

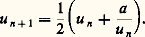

Les suites (a n ) et (b n ) sont adjacentes, et elles convergent toutes deux vers 見. En outre, pour tout entier naturel n , 見 appartient à l’intervalle [a n ,b n ].Dès le XVIe siècle, cette méthode est employée pour séparer les racines d’une équation algébrique. La convergence n’est pas très rapide; c’est pourquoi cette méthode n’est pas utilisée lorsqu’on désire obtenir 見 avec une grande précision.En revanche, le méthode de dichotomie a eu une importance considérable dans le développement des concepts fondamentaux de l’analyse:– Lagrange (1736-1813), dans La Théorie des fonctions analytiques (1797), utilise une variante de cette méthode pour démontrer le principe fondamental du calcul différentiel, suivant lequel une fonction admettant une dérivée positive est croissante; ce principe est à la base de la formule de Taylor.– Bolzano (1781-1848), dans Une preuve analytique ... (1817) et Cauchy (1789-1857), dans son Cours d’analyse à l’École polytechnique (1821), utilisent la dichotomie pour démontrer le théorème des valeurs intermédiaires.– L’école de Weierstrass (1815-1897) utilise systématiquement la dichotomie pour démontrer les théorèmes fondamentaux sur les fonctions continues (existence d’un maximum, continuité uniforme). Ces résultats reposent sur le théorème suivant, dit de Bolzano-Weierstrass: de toute suite bornée de nombres réels, on peut extraire une suite convergente.Méthode d’interpolation linéaire (ou «regula falsi»)Sous les mêmes hypothèses que précédemment, on cherche une valeur approchée 廓 de 諸 en interpolant g sur l’intervalle [a ,b ] par une fonction affine 﨏, et en définissant 廓 par la relation 﨏( 廓) = 0. Cette méthode a été utilisée par Viète (1540-1603) et par Descartes (1596-1650), dans le cas des équations algébriques. La majoration de l’erreur a été effectuée par Lagrange.Cette méthode est peu employée seule car elle ne conduit pas à un processus itératif qui soit à la fois commode et performant.Méthode des tangentes (ou de Newton)L’école d’Alexandrie, et en particulier Archimède, utilise fréquemment des encadrements des racines carrées d’un nombre entier par des nombres rationnels. À cet effet, on utilise l’algorithme d’Euclide de divisions successives. Héron d’Alexandrie part d’une autre idée. Pour approcher 連a , il écrit a sous la forme a = r 2 + b , où r est le plus grand des entiers p tels que p 2 諒 a . Ainsi, 連a = r 連1 + (b /r 2). Il approche 連1 + (b /r 2) par 1 + (b /2r 2). D’où la valeur approchée suivante: On itère alors ce processus. Plus précisément, on pose:

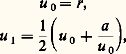

On itère alors ce processus. Plus précisément, on pose: et, pour tout entier naturel n ,

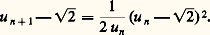

et, pour tout entier naturel n , La convergence de la suite (u n ) vers 連a est extraordinairement rapide. Ainsi, lorsque a = 2, u 0 = 1, u 1 = 1,5, u 2 = 1,416 666 66..., u 3 = 1,414 215 68..., u 4 = 1,414 213 56...Cette rapidité peut être prévue grâce aux encadrements suivants: on prouve d’abord que |u 2 漣 連2| 諒 1/400. Par ailleurs, pour tout entier naturel n ,

La convergence de la suite (u n ) vers 連a est extraordinairement rapide. Ainsi, lorsque a = 2, u 0 = 1, u 1 = 1,5, u 2 = 1,416 666 66..., u 3 = 1,414 215 68..., u 4 = 1,414 213 56...Cette rapidité peut être prévue grâce aux encadrements suivants: on prouve d’abord que |u 2 漣 連2| 諒 1/400. Par ailleurs, pour tout entier naturel n , En particulier, u 4 et u 5 fournissent respectivement des approximations de 連 2 à 10-11 près et à 10-23 près.Cette méthode est incomparablement supérieure à la méthode encore enseignée (pour des raisons inconnues) dans les lycées et collèges français, laquelle repose sur une décomposition en tranches de deux chiffres.La méthode de Héron est reprise par Newton dans son traité Principes mathématiques de la philosophie naturelle . Lors de l’étude du mouvement des planètes, il est amené à rechercher des solutions approchées de l’équation de Kepler x = a + e sin x , où e 麗 1. Plus généralement, pour chercher des solutions approchées de l’équation g (x ) = 0, on part d’une valeur initiale c et l’on prend pour valeur approchée l’abscisse b du point d’intersection avec Ox de la tangente au graphe de g au point d’abscisse c . On a:

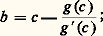

En particulier, u 4 et u 5 fournissent respectivement des approximations de 連 2 à 10-11 près et à 10-23 près.Cette méthode est incomparablement supérieure à la méthode encore enseignée (pour des raisons inconnues) dans les lycées et collèges français, laquelle repose sur une décomposition en tranches de deux chiffres.La méthode de Héron est reprise par Newton dans son traité Principes mathématiques de la philosophie naturelle . Lors de l’étude du mouvement des planètes, il est amené à rechercher des solutions approchées de l’équation de Kepler x = a + e sin x , où e 麗 1. Plus généralement, pour chercher des solutions approchées de l’équation g (x ) = 0, on part d’une valeur initiale c et l’on prend pour valeur approchée l’abscisse b du point d’intersection avec Ox de la tangente au graphe de g au point d’abscisse c . On a: on itère alors ce processus, grâce aux relations:

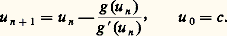

on itère alors ce processus, grâce aux relations: Cette méthode est connue sous le nom de méthode de Newton-Raphson. Cauchy fut le premier à préciser les conditions portant sur g assurant la convergence du processus (Cours d’analyse paru en 1821).La convergence est extrêmement rapide: on peut prouver qu’elle est de l’ordre de k (2n ). Il convient de remarquer que, si l’on applique la méthode de Newton à la résolution de l’équation x 2 漣 a = 0, on obtient précisément l’algorithme:

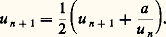

Cette méthode est connue sous le nom de méthode de Newton-Raphson. Cauchy fut le premier à préciser les conditions portant sur g assurant la convergence du processus (Cours d’analyse paru en 1821).La convergence est extrêmement rapide: on peut prouver qu’elle est de l’ordre de k (2n ). Il convient de remarquer que, si l’on applique la méthode de Newton à la résolution de l’équation x 2 漣 a = 0, on obtient précisément l’algorithme: Méthode des approximations successivesUn autre problème célèbre, dû à Ptolémée (128-168), est celui de la recherche de valeurs approchées de sin 10. (Ce problème apparaît dans la construction de tables trigonométriques.) Dans l’Almageste , Ptolémée calcule sin 720 et sin 600; il en déduit sin 120 puis, par dichotomies successives, sin 10 30 et sin 45 . Il effectue enfin une interpolation linéaire pour obtenir une valeur approchée de sin 10. Cette méthode fournit une valeur approchée à 10 -6 près. Les progrès de l’astronomie ont amené les mathématiciens arabes à améliorer cette précision. Vers 1400, al-Kashi, astronome à l’observatoire de Samarcande, part de la relation sin 3 x = 3 sin x 漣 4 sin3 x . Connaissant sin 30, il en déduit sin 10, en résolvant par approximations successives l’équation:

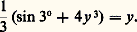

Méthode des approximations successivesUn autre problème célèbre, dû à Ptolémée (128-168), est celui de la recherche de valeurs approchées de sin 10. (Ce problème apparaît dans la construction de tables trigonométriques.) Dans l’Almageste , Ptolémée calcule sin 720 et sin 600; il en déduit sin 120 puis, par dichotomies successives, sin 10 30 et sin 45 . Il effectue enfin une interpolation linéaire pour obtenir une valeur approchée de sin 10. Cette méthode fournit une valeur approchée à 10 -6 près. Les progrès de l’astronomie ont amené les mathématiciens arabes à améliorer cette précision. Vers 1400, al-Kashi, astronome à l’observatoire de Samarcande, part de la relation sin 3 x = 3 sin x 漣 4 sin3 x . Connaissant sin 30, il en déduit sin 10, en résolvant par approximations successives l’équation:

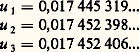

ici aussi, la convergence est extrêmement rapide, ainsi:

ici aussi, la convergence est extrêmement rapide, ainsi: On peut montrer a priori que le nombre u 3 fournit une approximation de sin 10 à 10 -10 près. En effet,

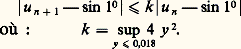

On peut montrer a priori que le nombre u 3 fournit une approximation de sin 10 à 10 -10 près. En effet, Cette méthode est reprise par Viète en 1600 et par Wallis en 1660, pour la résolution des équations algébriques.Là encore, c’est Cauchy qui a précisé les hypothèses assurant la convergence du processus. Voici l’énoncé général: soient I un intervalle fermé de R et f une application de I dans lui-même. On suppose que f est contractante, c’est-à-dire qu’il existe un nombre réel positif k strictement inférieur à 1 tel que, pour tout couple (x , y ) de points de I,

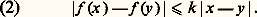

Cette méthode est reprise par Viète en 1600 et par Wallis en 1660, pour la résolution des équations algébriques.Là encore, c’est Cauchy qui a précisé les hypothèses assurant la convergence du processus. Voici l’énoncé général: soient I un intervalle fermé de R et f une application de I dans lui-même. On suppose que f est contractante, c’est-à-dire qu’il existe un nombre réel positif k strictement inférieur à 1 tel que, pour tout couple (x , y ) de points de I, Dans ces conditions, l’application f admet un point fixe a et un seul; en outre, pour tout élément c de I, la suite (u n ), définie par les relations u n + 1 = f (u n ) et u 0 = c , converge vers a . Enfin, pour tout entier naturel non nul p ,

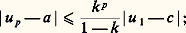

Dans ces conditions, l’application f admet un point fixe a et un seul; en outre, pour tout élément c de I, la suite (u n ), définie par les relations u n + 1 = f (u n ) et u 0 = c , converge vers a . Enfin, pour tout entier naturel non nul p , en particulier, la condition (2) est satisfaite lorsque f est dérivable sur I et que:

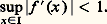

en particulier, la condition (2) est satisfaite lorsque f est dérivable sur I et que: Ainsi, la pente des tangentes au graphe de f gouverne la rapidité de convergence.Supposons maintenant que l’on veuille résoudre par cette méthode une équation de la forme g (x ) = 0, où g est de classe C1 sur un intervalle J de R, sachant qu’il existe un élément 見 de J et un seul tel que g ( 見) = 0; on suppose en outre que g ( 見) 0. L’idée consiste à écrire l’équation g (x ) = 0 sous la forme f (x ) = x , où:

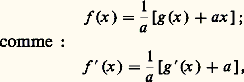

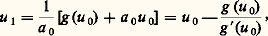

Ainsi, la pente des tangentes au graphe de f gouverne la rapidité de convergence.Supposons maintenant que l’on veuille résoudre par cette méthode une équation de la forme g (x ) = 0, où g est de classe C1 sur un intervalle J de R, sachant qu’il existe un élément 見 de J et un seul tel que g ( 見) = 0; on suppose en outre que g ( 見) 0. L’idée consiste à écrire l’équation g (x ) = 0 sous la forme f (x ) = x , où: on choisit a de telle sorte que, sur un voisinage I de 見 , | g (x ) + a | soit le plus petit possible; on applique à f la méthode des approximations successives. En particulier, ce procédé peut être employé pour une équation déjà mise sous la forme f (x ) = x , mais pour laquelle la convergence est trop lente. On dit alors qu’on effectue une accélération de convergence par ajustement linéaire.Le cas idéal est celui où, à chaque pas de l’itération, f (u n ) est nul; on peut s’y ramener en modifiant à chaque pas le facteur a . On obtient alors l’algorithme suivant pour résoudre l’équation g (x ) = 0. On pose u 0 = c ; il convient donc de prendre a 0 = 漣 g (u 0). Par suite:

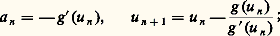

on choisit a de telle sorte que, sur un voisinage I de 見 , | g (x ) + a | soit le plus petit possible; on applique à f la méthode des approximations successives. En particulier, ce procédé peut être employé pour une équation déjà mise sous la forme f (x ) = x , mais pour laquelle la convergence est trop lente. On dit alors qu’on effectue une accélération de convergence par ajustement linéaire.Le cas idéal est celui où, à chaque pas de l’itération, f (u n ) est nul; on peut s’y ramener en modifiant à chaque pas le facteur a . On obtient alors l’algorithme suivant pour résoudre l’équation g (x ) = 0. On pose u 0 = c ; il convient donc de prendre a 0 = 漣 g (u 0). Par suite: et plus généralement:

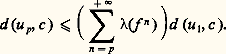

et plus généralement: on retombe alors sur la méthode de Newton.Néanmoins, lorsque l’expression de g est compliquée, la méthode de Newton est d’emploi peu commode. Il est alors préférable d’effectuer une accélération de convergence immuable.La méthode des approximations successives, issue du calcul numérique, a été employée par Picard (1856-1941), pour la recherche des solutions des équations différentielles. Au cours du XXe siècle, son champ d’application est élargi à tous les secteurs de l’analyse: équations implicites, équations aux dérivées partielles, traitement numérique des matrices, topologie algébrique, etc. On utilise à cet effet l’énoncé suivant: soit (A , d ) un espace métrique et f une application de A dans lui-même, telle que la série des rapports de Lipschitz(f n ) converge. Alors l’application f a un point fixe a et un seul. En outre, pour tout élément c de A, la suite (u n ) définie par les relations u n + 1 = f (u n ) et u 0 = c converge vers a . Enfin, pour tout entier naturel non nul p ,

on retombe alors sur la méthode de Newton.Néanmoins, lorsque l’expression de g est compliquée, la méthode de Newton est d’emploi peu commode. Il est alors préférable d’effectuer une accélération de convergence immuable.La méthode des approximations successives, issue du calcul numérique, a été employée par Picard (1856-1941), pour la recherche des solutions des équations différentielles. Au cours du XXe siècle, son champ d’application est élargi à tous les secteurs de l’analyse: équations implicites, équations aux dérivées partielles, traitement numérique des matrices, topologie algébrique, etc. On utilise à cet effet l’énoncé suivant: soit (A , d ) un espace métrique et f une application de A dans lui-même, telle que la série des rapports de Lipschitz(f n ) converge. Alors l’application f a un point fixe a et un seul. En outre, pour tout élément c de A, la suite (u n ) définie par les relations u n + 1 = f (u n ) et u 0 = c converge vers a . Enfin, pour tout entier naturel non nul p , Lorsque f est contractante,(f n ) 諒 k n , et on retrouve le cas classique. Mais l’énoncé précédent est plus précis; par exemple, dans le cas des équations différentielles, la convergence est d’ordre M n /n !.Comparaison des méthodes précédentesIl convient ici, comme dans tous les problèmes de calcul numérique, de distinguer trois niveaux:– celui de l’existence et de l’unicité des solutions, problème d’analyse mathématique;– celui de la rapidité de convergence des processus d’approximation, problème d’analyse numérique;– celui de la performance du processus, c’est-à-dire du temps total (et donc du coût) nécessaire pour effectuer le calcul avec un matériel donné et une précision donnée, problème de calcul numérique et d’informatique.Il faut en effet remarquer qu’un algorithme peut être plus rapidement convergent qu’un autre, tout en étant moins performant. Ainsi, la convergence d’un processus par trichotomie est d’ordre 1/3n , tandis que celle d’un processus par dichotomie est d’ordre 1/2n ; cependant, la dichotomie est plus performante car, à chaque pas, elle nécessite moins de calculs.Bien entendu, lorsque le calcul de g est simple, la méthode de Newton est la plus performante. Dans le cas contraire, on emploie une méthode d’approximations successives (avec éventuellement accélération de convergence). Cependant, ces méthodes ne sont performantes que dans la mesure où la valeur initiale c est assez proche de la racine. Pour obtenir de telles valeurs, on utilise couramment une dichotomie ou une interpolation linéaire.Valeurs approchées d’une fonction en un pointPour calculer les valeurs des fonctions transcendantes élémentaires, Newton puis Euler utilisent les développements en série entière de ces fonctions. On en trouve de nombreux exemples dans l’Introduction à l’analyse infinitésimale . La méthode suivie par Euler est de type expérimental: pour obtenir la somme d’une série numérique convergente avec vingt décimales, il calcule les termes successifs en s’arrêtant au premier terme inférieur à 10-20. En particulier, il calcule le nombre e avec vingt-trois décimales:

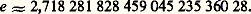

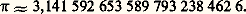

Lorsque f est contractante,(f n ) 諒 k n , et on retrouve le cas classique. Mais l’énoncé précédent est plus précis; par exemple, dans le cas des équations différentielles, la convergence est d’ordre M n /n !.Comparaison des méthodes précédentesIl convient ici, comme dans tous les problèmes de calcul numérique, de distinguer trois niveaux:– celui de l’existence et de l’unicité des solutions, problème d’analyse mathématique;– celui de la rapidité de convergence des processus d’approximation, problème d’analyse numérique;– celui de la performance du processus, c’est-à-dire du temps total (et donc du coût) nécessaire pour effectuer le calcul avec un matériel donné et une précision donnée, problème de calcul numérique et d’informatique.Il faut en effet remarquer qu’un algorithme peut être plus rapidement convergent qu’un autre, tout en étant moins performant. Ainsi, la convergence d’un processus par trichotomie est d’ordre 1/3n , tandis que celle d’un processus par dichotomie est d’ordre 1/2n ; cependant, la dichotomie est plus performante car, à chaque pas, elle nécessite moins de calculs.Bien entendu, lorsque le calcul de g est simple, la méthode de Newton est la plus performante. Dans le cas contraire, on emploie une méthode d’approximations successives (avec éventuellement accélération de convergence). Cependant, ces méthodes ne sont performantes que dans la mesure où la valeur initiale c est assez proche de la racine. Pour obtenir de telles valeurs, on utilise couramment une dichotomie ou une interpolation linéaire.Valeurs approchées d’une fonction en un pointPour calculer les valeurs des fonctions transcendantes élémentaires, Newton puis Euler utilisent les développements en série entière de ces fonctions. On en trouve de nombreux exemples dans l’Introduction à l’analyse infinitésimale . La méthode suivie par Euler est de type expérimental: pour obtenir la somme d’une série numérique convergente avec vingt décimales, il calcule les termes successifs en s’arrêtant au premier terme inférieur à 10-20. En particulier, il calcule le nombre e avec vingt-trois décimales: Dans le cas où la série donnée ne converge pas assez rapidement, Euler effectue des transformations sur cette série pour accélérer la convergence: il applique de tels procédés au calcul de log(1 + x ) et de Arctg x . En particulier, il obtient des méthodes très efficaces pour le calcul approché du nombre 神, qu’il obtient avec cent vingt décimales. En voici les premières:

Dans le cas où la série donnée ne converge pas assez rapidement, Euler effectue des transformations sur cette série pour accélérer la convergence: il applique de tels procédés au calcul de log(1 + x ) et de Arctg x . En particulier, il obtient des méthodes très efficaces pour le calcul approché du nombre 神, qu’il obtient avec cent vingt décimales. En voici les premières: Dans La Théorie des fonctions analytiques , Lagrange reprend les calculs précédents mais il établit des majorations des restes des séries considérées. De telles majorations ont joué un rôle important dans la construction du concept de convergence des séries, comme il apparaît dans le Cours d’analyse déjà cité de Cauchy.Développements asymptotiquesDès la fin du XVIIe siècle se pose le problème de l’évaluation des restes des séries convergentes et des sommes partielles des séries divergentes. Le premier cas se présente lors du calcul des sommes de séries convergeant lentement, telles que les séries de termes généraux 1/n 2 et 1/n 3. Le second cas apparaît à propos de l’étude de la série harmonique de terme général 1/n et du calcul des probabilités, lequel nécessite l’emploi de grands nombres, notamment n ! et Cp n .Newton, Jean Bernoulli et Stirling (1692-1770) résolvent ces problèmes sur des exemples. Euler en 1732 et Maclaurin en 1742, indépendamment, étudient le cas général. Un exposé synthétique, suivi de nombreuses applications, est donné par Euler dans les Institutiones calculi differentialis (1755). Bien entendu, la convergence des processus mis en jeu est traitée de manière expérimentale. Jacobi (1804-1851) et Cauchy établissent des majorations du reste de la formule d’Euler-Maclaurin. D’autres applications de cette formule sont dues à Abel (1802-1829), Gauss (1777-1855), Tchebychev (1821-1894) et Hermite (1822-1901).Pour les séries convergentes, on obtient le résultat suivant: soit f une fonction indéfiniment dérivable sur [1, + 秊[ à valeurs complexes, intégrable sur cet intervalle ainsi que ses dérivées jusqu’à l’ordre 2 r + 1. Si, en outre, chacune de ces dérivées est négligeable devant la précédente, la série de terme général f (n ) converge, et

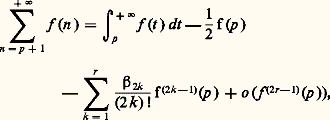

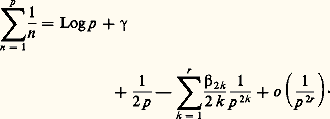

Dans La Théorie des fonctions analytiques , Lagrange reprend les calculs précédents mais il établit des majorations des restes des séries considérées. De telles majorations ont joué un rôle important dans la construction du concept de convergence des séries, comme il apparaît dans le Cours d’analyse déjà cité de Cauchy.Développements asymptotiquesDès la fin du XVIIe siècle se pose le problème de l’évaluation des restes des séries convergentes et des sommes partielles des séries divergentes. Le premier cas se présente lors du calcul des sommes de séries convergeant lentement, telles que les séries de termes généraux 1/n 2 et 1/n 3. Le second cas apparaît à propos de l’étude de la série harmonique de terme général 1/n et du calcul des probabilités, lequel nécessite l’emploi de grands nombres, notamment n ! et Cp n .Newton, Jean Bernoulli et Stirling (1692-1770) résolvent ces problèmes sur des exemples. Euler en 1732 et Maclaurin en 1742, indépendamment, étudient le cas général. Un exposé synthétique, suivi de nombreuses applications, est donné par Euler dans les Institutiones calculi differentialis (1755). Bien entendu, la convergence des processus mis en jeu est traitée de manière expérimentale. Jacobi (1804-1851) et Cauchy établissent des majorations du reste de la formule d’Euler-Maclaurin. D’autres applications de cette formule sont dues à Abel (1802-1829), Gauss (1777-1855), Tchebychev (1821-1894) et Hermite (1822-1901).Pour les séries convergentes, on obtient le résultat suivant: soit f une fonction indéfiniment dérivable sur [1, + 秊[ à valeurs complexes, intégrable sur cet intervalle ainsi que ses dérivées jusqu’à l’ordre 2 r + 1. Si, en outre, chacune de ces dérivées est négligeable devant la précédente, la série de terme général f (n ) converge, et où les nombres 廓n sont les nombres de Bernoulli, définis par la relation:

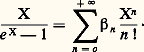

où les nombres 廓n sont les nombres de Bernoulli, définis par la relation: En particulier, 廓0 = 1, 廓1 = 漣 1/2, 廓2p+1 = 0 si p 閭 1, 廓2 = 1/6, 廓4= 漣1/30, 廓6 = 1/42, 廓8 = 漣 1/30, 廓10 = 5/66.Euler détermine ainsi la somme de la série de terme général 1/n 3 à la précision 10-10, en calculant seulement la somme des douze premiers termes et en évaluant le reste par la formule sommatoire. Une méthode directe aurait nécessité le calcul de plus de soixante-dix mille termes.Pour les séries divergentes, le résultat est analogue: on suppose que f et ses dérivées jusqu’à l’ordre 2 h 漣 1 ne sont pas intégrables, tandis que les dérivées de l’ordre 2 h à l’ordre 2 r + 1 le sont. Si, en outre, chacune de ces dérivées est négligeable devant la précédente, la série de terme général f (n ) diverge, et il existe un nombre complexe c tel que:

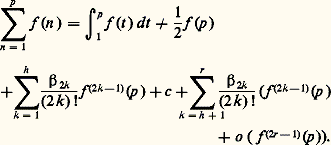

En particulier, 廓0 = 1, 廓1 = 漣 1/2, 廓2p+1 = 0 si p 閭 1, 廓2 = 1/6, 廓4= 漣1/30, 廓6 = 1/42, 廓8 = 漣 1/30, 廓10 = 5/66.Euler détermine ainsi la somme de la série de terme général 1/n 3 à la précision 10-10, en calculant seulement la somme des douze premiers termes et en évaluant le reste par la formule sommatoire. Une méthode directe aurait nécessité le calcul de plus de soixante-dix mille termes.Pour les séries divergentes, le résultat est analogue: on suppose que f et ses dérivées jusqu’à l’ordre 2 h 漣 1 ne sont pas intégrables, tandis que les dérivées de l’ordre 2 h à l’ordre 2 r + 1 le sont. Si, en outre, chacune de ces dérivées est négligeable devant la précédente, la série de terme général f (n ) diverge, et il existe un nombre complexe c tel que: En appliquant cette formule à la série harmonique, Euler obtient la relation:

En appliquant cette formule à la série harmonique, Euler obtient la relation: Il en déduit facilement 塚 avec quinze décimales:

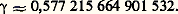

Il en déduit facilement 塚 avec quinze décimales: Une méthode directe, consistant à calculer:

Une méthode directe, consistant à calculer: nécessiterait le calcul de 5 憐 1014 termes.De même, en appliquant la formule sommatoire à la série de terme général log n , on obtient la formule de Stirling:

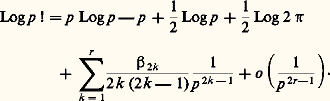

nécessiterait le calcul de 5 憐 1014 termes.De même, en appliquant la formule sommatoire à la série de terme général log n , on obtient la formule de Stirling: Euler obtient plus généralement un développement asymptotique de log 臨(x ).La notion de développement asymptotique n’a pas été clarifiée avant la fin du XIXe siècle. Une confusion a eu lieu entre développements asymptotiques et développements en série. Poincaré (1854-1912) et Borel (1871-1956) codifièrent l’emploi des premiers. On trouve un exposé synthétique dans les Leçons sur les séries divergentes (1901) de Borel.Notons enfin que le calcul numérique a joué un rôle important dans l’obtention de développements asymptotiques pour les fonctions arithmétiques, et en particulier dans l’évaluation du nombre 神(n ) de nombres premiers inférieurs à n . Ainsi, Legendre a conjecturé que 神(n ) est de l’ordre de:

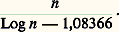

Euler obtient plus généralement un développement asymptotique de log 臨(x ).La notion de développement asymptotique n’a pas été clarifiée avant la fin du XIXe siècle. Une confusion a eu lieu entre développements asymptotiques et développements en série. Poincaré (1854-1912) et Borel (1871-1956) codifièrent l’emploi des premiers. On trouve un exposé synthétique dans les Leçons sur les séries divergentes (1901) de Borel.Notons enfin que le calcul numérique a joué un rôle important dans l’obtention de développements asymptotiques pour les fonctions arithmétiques, et en particulier dans l’évaluation du nombre 神(n ) de nombres premiers inférieurs à n . Ainsi, Legendre a conjecturé que 神(n ) est de l’ordre de: Gauss a amélioré cette hypothèse, en comparant expérimentalement 神(n ) au logarithme intégral de n , défini par la relation:

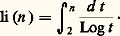

Gauss a amélioré cette hypothèse, en comparant expérimentalement 神(n ) au logarithme intégral de n , défini par la relation: Par une méthode très performante de calcul approché des intégrales, à laquelle son nom est resté attaché, il obtient la relation:

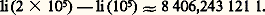

Par une méthode très performante de calcul approché des intégrales, à laquelle son nom est resté attaché, il obtient la relation: Il compare ensuite ce nombre à 神(2 憐 105) 漣 神(105). Ces conjectures ont été à l’origine des travaux de Tchebychev, d’Hadamard et de La Vallée-Poussin. On a maintenant démontré (cf. théorie des NOMBRES - Théorie analytique des nombres) que:

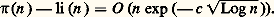

Il compare ensuite ce nombre à 神(2 憐 105) 漣 神(105). Ces conjectures ont été à l’origine des travaux de Tchebychev, d’Hadamard et de La Vallée-Poussin. On a maintenant démontré (cf. théorie des NOMBRES - Théorie analytique des nombres) que: Interpolation des fonctionsComme nous l’avons signalé, l’interpolation linéaire était déjà utilisée par l’école d’Alexandrie. C’est Briggs qui systématisa l’emploi de l’interpolation pour l’établissement des tables de logarithmes et des tables trigonométriques, via le calcul des différences finies. Gregory et Newton étendirent le calcul des différences finies aux fonctions quelconques. Newton distingue le cas des pas constants du cas général, où il introduit la notion de différence divisée. L’étude de l’interpolation d’une fonction par un polynôme de degré inférieur à un entier donné est approfondie par Lagrange, en liaison avec celle des opérateurs aux différences finies, pour laquelle il introduit la notion fondamentale de série génératrice. Enfin, Laplace (1749-1827) étudie systématiquement ces séries et les applique dans des secteurs très variés (calcul des probabilités, équations aux différences finies, combinatoire).Tous les calculs précédents sont de type formel. Cependant, Cauchy évalue l’erreur commise en remplaçant une fonction f définie sur un intervalle [a , b ] par le polynôme P interpolant f en des points 見0, 見1, ..., 見n :

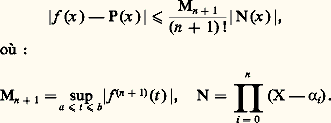

Interpolation des fonctionsComme nous l’avons signalé, l’interpolation linéaire était déjà utilisée par l’école d’Alexandrie. C’est Briggs qui systématisa l’emploi de l’interpolation pour l’établissement des tables de logarithmes et des tables trigonométriques, via le calcul des différences finies. Gregory et Newton étendirent le calcul des différences finies aux fonctions quelconques. Newton distingue le cas des pas constants du cas général, où il introduit la notion de différence divisée. L’étude de l’interpolation d’une fonction par un polynôme de degré inférieur à un entier donné est approfondie par Lagrange, en liaison avec celle des opérateurs aux différences finies, pour laquelle il introduit la notion fondamentale de série génératrice. Enfin, Laplace (1749-1827) étudie systématiquement ces séries et les applique dans des secteurs très variés (calcul des probabilités, équations aux différences finies, combinatoire).Tous les calculs précédents sont de type formel. Cependant, Cauchy évalue l’erreur commise en remplaçant une fonction f définie sur un intervalle [a , b ] par le polynôme P interpolant f en des points 見0, 見1, ..., 見n : À propos d’une question de mécanique (régulateur de Watt), Tchebychev est amené à rechercher l’optimisation de l’approximation de f par P, n étant donné. Cela revient à choisir les points 見0, 見1, ..., 見n de sorte que:

À propos d’une question de mécanique (régulateur de Watt), Tchebychev est amené à rechercher l’optimisation de l’approximation de f par P, n étant donné. Cela revient à choisir les points 見0, 見1, ..., 見n de sorte que: soit le plus petit possible. On se ramène par homothétie et translation au cas où a = 漣 1 et b = 1. Il convient alors de prendre pour N l’unique polynôme Tn tel que Tn (cos t ) = cos nt . Les valeurs de 見0, 見1, ..., 見n s’en déduisent. Pour un exposé de la théorie de l’interpolation, se reporter à l’article: approximation et représentation des FONCTIONS.Nombres attachés à une fonctionLe calcul approché des dérivées par utilisation des différences finies est élaboré par Newton et Euler.Pour le calcul approché de l’intégrale I d’une fonction f sur un intervalle [a , b ], la méthode consiste à introduire une subdivision (a 0, a 1, ..., a p ) de [a , b ] et à remplacer, sur chaque intervalle [a j , a j+1 ], la fonction f par un polynôme interpolateur de degré n . Posons 見 = a j et 廓 = a j+1 ,.– Le cas où n = 1 (déjà employé par l’école d’Alexandrie sur des exemples d’exhaustion) est connu sous le nom de méthode des trapèzes. Cela revient à écrire:

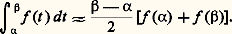

soit le plus petit possible. On se ramène par homothétie et translation au cas où a = 漣 1 et b = 1. Il convient alors de prendre pour N l’unique polynôme Tn tel que Tn (cos t ) = cos nt . Les valeurs de 見0, 見1, ..., 見n s’en déduisent. Pour un exposé de la théorie de l’interpolation, se reporter à l’article: approximation et représentation des FONCTIONS.Nombres attachés à une fonctionLe calcul approché des dérivées par utilisation des différences finies est élaboré par Newton et Euler.Pour le calcul approché de l’intégrale I d’une fonction f sur un intervalle [a , b ], la méthode consiste à introduire une subdivision (a 0, a 1, ..., a p ) de [a , b ] et à remplacer, sur chaque intervalle [a j , a j+1 ], la fonction f par un polynôme interpolateur de degré n . Posons 見 = a j et 廓 = a j+1 ,.– Le cas où n = 1 (déjà employé par l’école d’Alexandrie sur des exemples d’exhaustion) est connu sous le nom de méthode des trapèzes. Cela revient à écrire: – Le cas où n = 2 est connu sous le nom de méthode de Simpson (1743), mais il apparaît déjà chez Cavalieri en 1639. Cela revient à écrire (formule des trois niveaux):

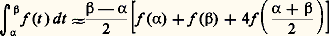

– Le cas où n = 2 est connu sous le nom de méthode de Simpson (1743), mais il apparaît déjà chez Cavalieri en 1639. Cela revient à écrire (formule des trois niveaux): – Le cas où n = 3 est utilisé par Newton. Cela revient à écrire:

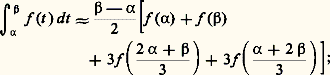

– Le cas où n = 3 est utilisé par Newton. Cela revient à écrire: – Le cas général a été étudié par Newton et Cotes (1682-1716).Une méthode plus élaborée est mise au point par Euler; elle s’appuie sur la formule d’Euler-Maclaurin. La méthode de Gauss (1814) consiste à optimiser l’erreur commise sur:

– Le cas général a été étudié par Newton et Cotes (1682-1716).Une méthode plus élaborée est mise au point par Euler; elle s’appuie sur la formule d’Euler-Maclaurin. La méthode de Gauss (1814) consiste à optimiser l’erreur commise sur: Il convient de souligner que, dans ces dernières méthodes, les concepts fondamentaux de l’analyse, en particulier l’intégration par parties, prennent le relais de l’intuition géométrique, laquelle inspirait les méthodes élémentaires.Approximation des fonctionsLe problème consiste à approcher une fonction f sur un intervalle [a , b ] par des fonctions se prêtant mieux au calcul.Au XVIIe siècle, on a utilisé l’interpolation par des polynômes de petit degré. Avec Newton et Leibniz apparaît l’emploi de développements en série entière. L’optimisation de telles approximations a fait l’objet de nombreux travaux: méthode des moindres carrés (Legendre, 1805, et Gauss, 1809), développement en série de polynômes de Tchebychev, théorie de la meilleure approximation uniforme (Bernstein et La Vallée-Poussin).Un autre courant s’est développé à partir des travaux de Fourier (1768-1830), engagés dès 1807, et exposés dans la Théorie analytique de la chaleur (1822). Fourier approche les fonctions périodiques par des polynômes trigonométriques. Ces travaux ont conduit à l’étude de la meilleure approximation en moyenne quadratique et des développements en séries de fonctions orthogonales (cf. approximation et représentation des FONCTIONS et polynômes ORTHOGONAUX).Paradoxalement, ce sont les problèmes de calcul numérique concernant les cordes vibrantes et la propagation de la chaleur qui ont amené à élargir le champ des fonctions. Les travaux de Dirichlet (1829) et de Riemann (1854) sur l’intégration et sur les séries trigonométriques, et même ceux de Cantor sur les ensembles de points (1871) y puisent leur origine.Bien d’autres secteurs mathématiques mettent en jeu de manière essentielle le calcul numérique. Citons par exemple la résolution des systèmes linéaires, l’inversion des matrices, la recherche des vecteurs propres et des valeurs propres, la résolution des équations différentielles et des équations aux dérivées partielles, l’optimisation.

Il convient de souligner que, dans ces dernières méthodes, les concepts fondamentaux de l’analyse, en particulier l’intégration par parties, prennent le relais de l’intuition géométrique, laquelle inspirait les méthodes élémentaires.Approximation des fonctionsLe problème consiste à approcher une fonction f sur un intervalle [a , b ] par des fonctions se prêtant mieux au calcul.Au XVIIe siècle, on a utilisé l’interpolation par des polynômes de petit degré. Avec Newton et Leibniz apparaît l’emploi de développements en série entière. L’optimisation de telles approximations a fait l’objet de nombreux travaux: méthode des moindres carrés (Legendre, 1805, et Gauss, 1809), développement en série de polynômes de Tchebychev, théorie de la meilleure approximation uniforme (Bernstein et La Vallée-Poussin).Un autre courant s’est développé à partir des travaux de Fourier (1768-1830), engagés dès 1807, et exposés dans la Théorie analytique de la chaleur (1822). Fourier approche les fonctions périodiques par des polynômes trigonométriques. Ces travaux ont conduit à l’étude de la meilleure approximation en moyenne quadratique et des développements en séries de fonctions orthogonales (cf. approximation et représentation des FONCTIONS et polynômes ORTHOGONAUX).Paradoxalement, ce sont les problèmes de calcul numérique concernant les cordes vibrantes et la propagation de la chaleur qui ont amené à élargir le champ des fonctions. Les travaux de Dirichlet (1829) et de Riemann (1854) sur l’intégration et sur les séries trigonométriques, et même ceux de Cantor sur les ensembles de points (1871) y puisent leur origine.Bien d’autres secteurs mathématiques mettent en jeu de manière essentielle le calcul numérique. Citons par exemple la résolution des systèmes linéaires, l’inversion des matrices, la recherche des vecteurs propres et des valeurs propres, la résolution des équations différentielles et des équations aux dérivées partielles, l’optimisation.

Encyclopédie Universelle. 2012.